Le molteplici stazioni meteo, collocate nei punti più disparati del Globo, attraverso una prima stesura matematica (elaborazione) sono in grado di produrre migliaia di misurazioni ed inviarle, con intervalli cadenzati, al centro principale che ne rielabora a sua volta i dati.

Ovviamente non tutte le stazioni di rilevazione possiedono gli stessi elaboratori, quindi nella fase di trasmissione potrebbero arrivare elementi, non perfettamente filtrati e “distorti” a destinazione.

La figura umana, l’interprete che coglie queste dissonanze, viene sempre messo in primo piano nel sistema previsionale costituito da un complesso “grigliato”.

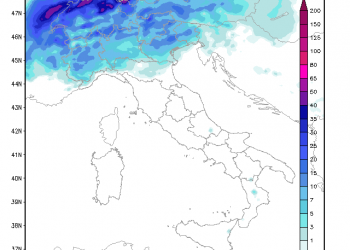

Gli “osservatori” del tempo quindi procedono per strutture ben definite: essi “testano”, o misurano l’ampiezza di ogni singola griglia, con intercalare ben preciso. Si può partire da un’ora (tempo sinottico) sino ad intervalli di 3/6 h.

Sappiamo benissimo che i dati principali che vengono trasmessi riguardano principalmente: la temperatura minima e massima, la tipologia del fenomeno (qualità e tipo di evento atmosferico), l’ UR, la velocità del vento e relativa direzione, la pressione atmosferica e la morfologia delle nubi fotografate in tempo reale.

Tutte queste informazione necessitano di una rapidissima divulgazione e conversione immediata in codici numerici “standard”. Deve seguire una “ultra celere” trasmissione ai centri meteo regionali o nazionali ed incanalati simultaneamente ai centri internazionali mondiali tramite una complessa rete GTS.

A tutto ciò si sommano le rilevazione oceanografiche, quelle satellitari, quelle atmosferiche, tramite sonde e quelle dei satelliti polari.

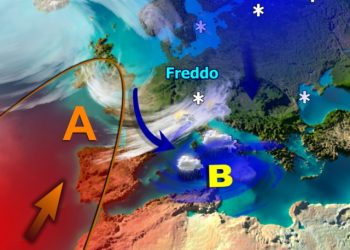

L’atmosfera deve necessariamente, stato di partenza, corrispondere il più possibile circa le condizioni fisiche, lette in un punto ipotetico di partenza = 0.

Se solo uno di questi elementi viene a mancare, anche per pochi minuti, quindi trasmesso con ritardo, non si ottiene mai una “fotografia”, la più realistica possibile, dello stato in cui versa l’atmosfera (tempo X+0).

Quindi l’espressione numerica previsionale testata e monitorata di ora in ora, o ogni 3/6 h., non è altro, per mancanza anche di dati provenienti dalle distese oceaniche, che una “teorica” ricostruzione dello stato iniziale e di partenza.

I più famosi centri previsionali mondiali, cui facciamo spesso i nostri riferimenti, acquisendo dati da diverse fonti, devono riuscire ad identificare, quantizzare, l’errore ricevuto per inserirlo nel modello (processore matematico) riducendone l’ampiezza (ultradecimale) in fase di emissione.

Quindi ogni elaborazione, non corrisponderà mai a quel famoso “punto di partenza zero”, ma è da considerasi “svincolata” e a se stante, rispetto alle emissioni precedenti.

Se vogliamo tornare al caso GFS, varie emissioni, la loro differenza non è da rintracciarsi nella diversità dei parametri (elementi in ingresso) in uso, ma nella corsa “sfrenata” verso un punto “ideale” atmosferico privo di errori e carenze.